Ethique des vertus

Définition

L’éthique des vertus d'Aristote place le bonheur et la vertu comme concepts centraux de sa philosophie. Elle considère que le but ultime de tout être humain est d'atteindre le bonheur par le moyen d'actions bonnes et vertueuses. Une action est considérée comme bonne si l'intention derrière l'est aussi, elle ne doit pas être guidée par une norme ou une règle mais uniquement par les vertus de l'acteur.

Analyse

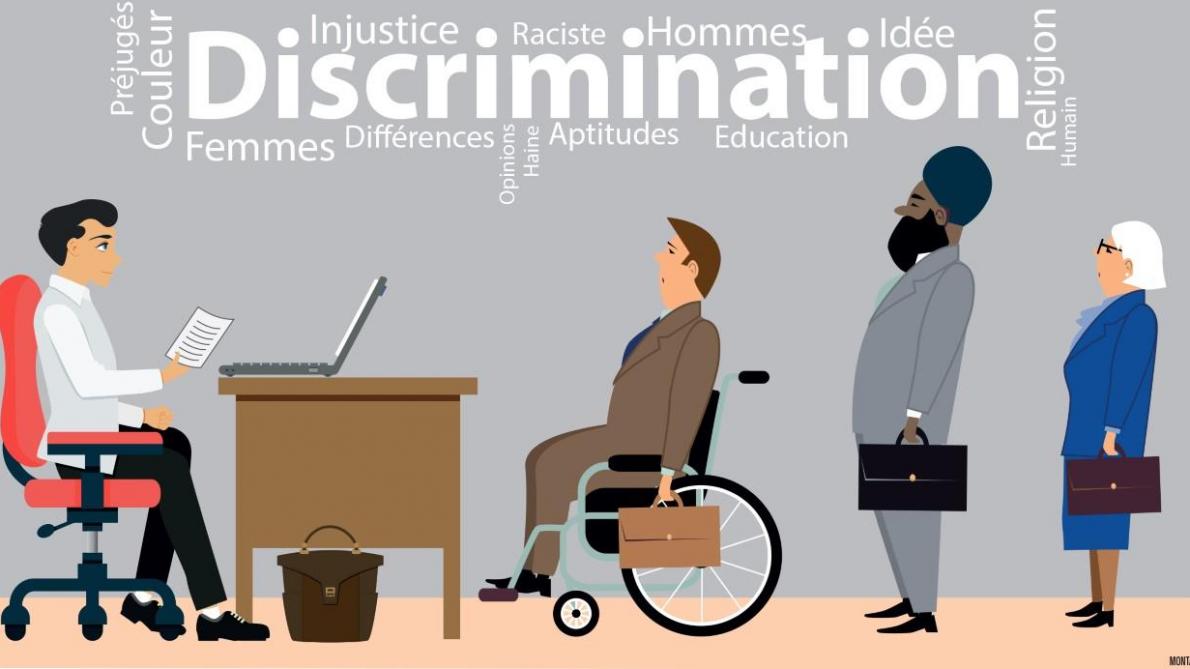

Le concept de discrimination par l'IA peut être analysé selon cette éthique des vertus et apporter une réponse sur la "bonne" marche à suivre pour la conception et l'utilisation d'algorithmes d'intelligence artificielle pouvant être discriminants. La valeur intrinsèque en jeu dans notre cas est l'égalité. La vertu associée est celle de la justice. L'action juste serait de traiter tout le monde de la même façon, de ne pas faire de distinction entre deux personnes selon un critère qui serait injuste tel que l'origine, le genre ou la religion.

Prenons quelques cas d'application concrets : le tri de CV à l'embauche, les recherches Internet et les tests sur les médicaments. Nous pouvons aussi analyser brièvement la discrimination positive.

Pour le tri de CV, il faudrait, selon l'éthique des vertus, ne pas employer d'intelligence artificielle qui engendrerait des injustices donc une inégalité. Nous pouvons cependant nuancer le propos avec une autre vertu : la modération. Utiliser l'intelligence artificielle avec modération permettrait de n'en tirer que le côté positif, c'est-à-dire utiliser l'algorithme mais pas en totalité. Plutôt que de ne pas en faire usage, garder un certain contrôle et n'en garder que les aspects positifs, même avec des performances moindres (ce qui reste encore à prouver).

Les recherches Internet sexistes quant à elles soulignent la vertu de courage. Les personnes développant l'IA ainsi que les différents responsables devraient faire en sorte que ce type de stéréotype discriminant n'apparaisse plus, en assumant avec courage que leurs utilisateurs seront (peut-être) moins satisfaits de la pertinence des recherches. La bienveillance aussi est une vertu candidate. La bonne attitude serait de contribuer à un monde meilleur sans dégradation de l'image d'une certaine partie de la population.

Les tests sur les médicaments calibrés le plus souvent pour des hommes blancs font en plus appel à la vertu d'honnêteté. L'attitude juste serait tout d'abord une transparence vis-à-vis des utilisateurs de médicaments sur le type et la proportion de personnes testées en fonction de différentes caractéristiques. En plus de ça, une meilleure représentation dans la population testée avant l'utilisation de l'IA guidée par la valeur d'égalité.

Enfin, la discrimination positive est considérée comme juste par l'éthique des vertus, étant donné qu'elle permet de diminuer un déséquilibre qui engendre des inégalités. La fraternité peut elle aussi être soulignée pour ce cas-ci.

Ethique des devoirs

«Un déontologiste considère que la bonne action est celle qui est posée parce qu'elle est requise par la loi morale. »

Selon Kant, l’humain est guidé dans ses actes par sa propre loi intérieure. La liberté implique d’être soumis à ses propres lois. L’action doit remplir certains devoirs en fonction du contexte (respect de la Loi, respect du sens moral et des obligations).

Nous pouvons considérer que nous agissons selon des maximes. D’après Kant, afin de déterminer si cette maxime selon laquelle nous agissons est éthique, il faut qu’elle respecte 3 principes : le principe d’universalisation, de dignité humaine et de légalisation.

Le principe d’universalisation: « Agis uniquement d’après la maxime qui fait que tu puisses vouloir en même temps qu’elle devienne une loi universelle de la nature ».

Le principe de dignité humaine: « Agis de telle sorte que tu traites l’humanité aussi bien dans ta personne que dans la personne de tout autre, toujours en même temps comme une fin, et jamais simplement comme un moyen ».

Principe de législation: « N’accomplis d’action que selon une maxime telle qu’elle puisse comporter en outre d’être une loi universelle, telle donc seulement que la volonté puisse se considérer elle-même comme constituant en même temps par sa maxime une législation universelle ».

Il est de notre devoir, en tant qu’êtres-humains, de ne pas discriminer d’autres êtres humains et de ne pas alimenter ces discriminations. Dans le cadre de l’Intelligence Artificielle, il est du devoir des développeurs de ne pas discriminer certains groupes de personnes. L’IA permet des avancées significatives notamment dans l’automatisation de certains procédés. Cependant, il faut veiller à ce que cette nouvelle technologie, capable de prendre des décisions de plus ou moins grande importance, ne soit pas biaisée.

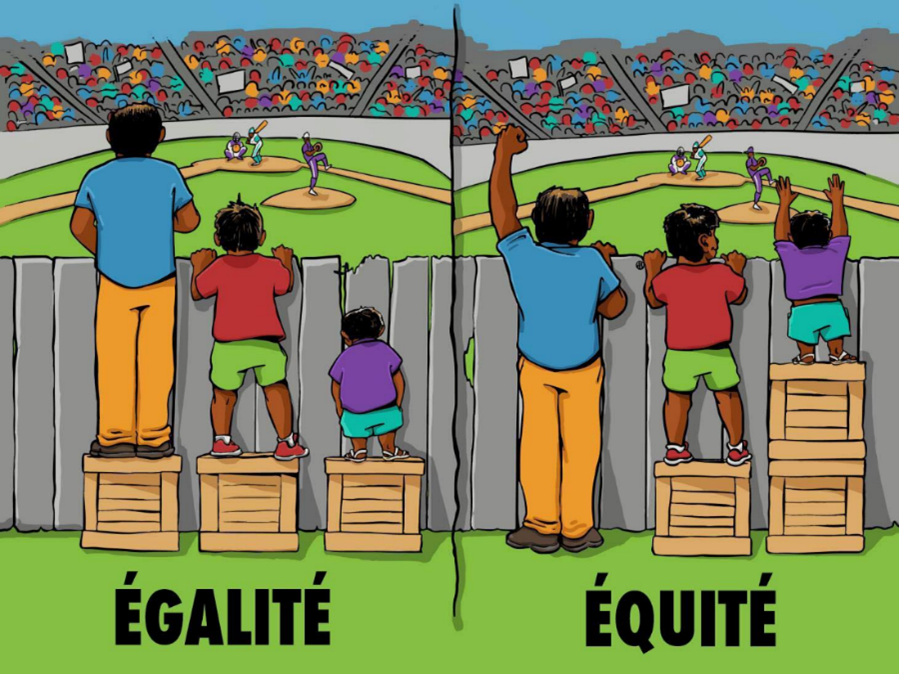

L’IA est entraînée sur des jeux de données et parfois ceux-ci manquent de diversité. Cela peut s’avérer vraiment problématique dans de nombreuses situations, par exemple dans le domaine médical où l’IA permet de proposer des traitements adaptés aux patients. Les personnes racisées ou les femmes sont souvent les moins représentées et cela mène à des propositions de traitements moins efficaces voire dangereux dues aux différences physiologiques. Dans ce cas, on rompt le principe d’universalisation car cela va à l’encontre des intérêts fondamentaux des êtres humains. Personne n’aimerait se voir attribuer un mauvais traitement parce qu’il y a de la discrimination dans les données d’entraînement. Prenons l’exemple des femmes, certaines informations supplémentaires doivent être prises en compte par rapport à l’homme occidental classique au niveau des différences métaboliques. Il s’agirait donc de ne pas imposer le même nombre de données pour les hommes et pour les femmes ni même de les comparer sur les mêmes critères, mais d’adapter les informations en fonction du genre, de l’ethnie, etc. L’important ici n’est pas l’égalité mais l’équité dans les jeux de données d’entraînement.

Les développeurs ont un devoir de créer des IA les plus performantes possibles, satisfaisants les utilisateurs au maximum. Cependant, proposer des résultats les plus souhaités n’est pas forcément une bonne chose, comme dans l’exemple de la recherche Google « écolier/écolière ». Ce résultat de recherche, disponible aux yeux de tous, est discriminant envers les femmes. On se trouve dans un cas où la performance s’oppose au principe de législation (les discriminations ne sont pas légales). Or, cela est causé par un problème de masse : les fantasmes d’hommes sur des écolières. Il est clair que cela n’est pas tolérable par la loi morale mais la question est de trouver qui doit poser les limites et où celles-ci doivent être posées. On en arrive à une nouvelle notion intéressante, celle de la discrimination positive. Il serait intéressant de pouvoir écarter des recherches jugées discriminantes afin qu’elles n’influencent pas les nouveaux résultats proposés.

Certaines limites pourraient être posées par la Loi mais d’autres devraient être posées par le sens moral, en écartant par exemple certaines opinions (ouvertement sexistes ou racistes ou autre), ce qui serait contraire à la liberté d’expression et ouvrirait la porte à « l’imposition » de la façon de penser. Il y a des cas où il semble évident de distinguer le « bien » du « mal », mais chacun trouve en lui sa propre notion du bien et du mal. En effet, il serait facile de diriger les mentalités vers celle que l’on désire, ce qui reviendrait à rompre le principe de dignité humaine, en utilisant l’humain comme un moyen, en le manipulant. Les personnes ayant le pouvoir de modifier l’algorithme seraient donc capables d’imposer leur propre façon de penser aux autres, et ce, qu’elle soit bonne ou mauvaise. C’est donc très compliqué de savoir quoi faire, qui laisser poser les limites, où les poser…

Ethique des conséquences

Le conséquentialisme peut être définit comme suit : "la valeur morale d'une action dépend des conséquences attendues de cette action sur le monde".

Si on décortique cette phrase, on peut premièrement noter que le mot "attendues" montre que l'intention que l'on a en agissant prime sur les conséquences réelles de cette action. Ensuite, en précisant "sur le monde", on insiste sur le fait qu'on ne doit pas simplement prendre en compte les conséquences qui nous impactent personnellement, mais bien envisager celles que nos actions ont sur le monde, ou du moins sur les personnes qui seront impactées par ces dernières.

L'éthique des conséquences évalue donc les actes bons ou mauvais en fonction de leurs conséquences. Donc, une action est moralement bonne si les conséquences qu'elle implique sont bonnes.

L'utilitarisme est une branche du conséquentialisme introduite par Jérémy Bentham, qui vise à maximiser les intérêts et le bien-être collectif. Cette doctrine se base sur la notion d'utilité, qui est un « principe qui approuve ou désapprouve toute action en accord avec la tendance à augmenter ou à diminuer le bonheur de la partie dont l'intérêt est en question ». Cette notion permet, selon les utilitaristes, de déterminer si une action est bonne ou mauvaise.

La notion d'utilité selon Bentham : « Additionnez toutes les valeurs de l’ensemble des plaisirs d’un côté, et celles de l’ensemble de peines de l’autre. Si la balance penche du côté du plaisir, elle indiquera la bonne tendance générale de l’acte, du point de vue des intérêts de telle personne individuelle ; si elle penche du côté de la peine, elle indiquera la mauvaise tendance de l’acte. ».

D'un point de vue général, l'utilisation de l'IA entraîne des conséquences à priori positives : gain de temps, réduction des risques humains, avancées pour les sciences des données… Mais si les IA répètent des schémas discriminatoires, cela engendre aussi des effets négatifs : créer des discriminations peut engendrer une injustice, et un mal-être chez les personnes qui en sont "victimes", mais aussi des conséquences plus graves si on utilise les IA discriminantes dans la justice ou la médecine par exemple.

Analysons plusieurs cas selon l'utilitarisme de Bentham.

Premièrement, étudions le cas de Tay, l'IA de Microsoft lancée sur Twitter en 2016, et qui apprenait avec les réponses et commentaires des utilisateurs. Il n'a pas fallu attendre 24h pour que cette IA tienne des propos racistes, misogynes, et même fascistes. Dans ce cas-ci, les peines dépassent clairement les plaisirs. Seulement, on ne peut pas vraiment dire qu'il s'agisse d'une action moralement mauvaise, puisque ce sont des conséquences auxquelles Microsoft ne pouvait pas s'attendre. Or, on ne peut pas juger sur des conséquences inattendues comme celles-ci, sinon cela reviendrait à évaluer des actions sur un critère de chance. En revanche, ce qui serait mauvais serait de laisser cette IA fonctionner en sachant qu'elle tient de tels propos. Microsoft a donc pris la bonne décision en suspendant le compte Twitter.

Ensuite, revenons sur le cas du tri des CV. En 2014, Amazon a voulu utiliser un algorithme de tri de CV qui, se basant sur les employé.e.s travaillant déjà dans l'entreprise, favorisait dans la sélection les hommes au détriment des femmes. L'utilisation d'un tel algorithme a comme plaisir le gain de temps et la facilité, et comme peine la discrimination à l'embauche. Puisque le conséquentialisme prend en compte les conséquences sur le monde et pas simplement les conséquences individuelles, l'emploi de cet algorithme ne peut pas être considéré comme éthiquement bon. La conclusion est la même dans le cas d'utilisation d'IA dans le domaine de la justice ou de la médecine. Même si ces intelligences font gagner du temps et semblent limiter les erreurs dans un premier temps, si elles ne traitent pas de la même façon les personnes noires et les personnes blanches, les hommes et les femmes, elles finissent donc par causer plus de peines que de plaisirs à la Société.

Enfin, les résultats de recherches internet sexistes peuvent apporter comme plaisir la satisfaction des utilisateurs, et comme peines, ils renforcent les stéréotypes de genre, et l'objectification de la femme. Il est un peu plus délicat de calculer l'utilité de cet exemple, car il est difficile d'évaluer précisément la valeur de la somme des plaisirs, et celle des peines. En effet, cela dépend de chacun, et les deux sont d'une ampleur globale. Nous pouvons tout de même dire qu'au final, les peines l'emportent sur les plaisirs, car elles ont un gros impact, tandis que les plaisirs sont plus temporaires, et n'impliquent pas de lourdes conséquences.