Sondage et avis du public

Afin de recueillir des opinions variées, nous avons réalisé un sondage en ligne, comportant 12 questions. Le sondage a reçu plus de 80 réponses, que nous allons analyser.

Les deux premières questions concernent le profil des personnes répondant au questionnaire, et plus précisément leur genre et leur âge. Pour ce qui est du genre, nous avons réussi à atteindre un public assez équitable, avec presque autant de femmes que d'hommes (49,4% d'hommes pour 45,8% de femmes, avec 4,8% de personnes de souhaitant pas le préciser). Pour ce qui est de l'âge, la répartition n'est pas aussi équitable : la majorité écrasante (79,5%) est composée de personnes entre 18 et 25 ans. Seulement 1,2% des participants sont âgés de moins de 18 ans. Le reste est constitué de personnes de plus de 25 ans.

Ensuite, à la question "Savez-vous ce qu'est l'Intelligence Artificielle ?", 95,2% ont répondu positivement.

Nous avons donc touché un public dont la répartition hommes-femmes est équitable, mais principalement de jeunes adultes et qui estime connaître les IA.

La question posée après est la suivante : "Pensez-vous qu'une IA puisse faire des discriminations (en fonction du genre, de la couleur de peau...) ?". La majorité des personnes (70,2%) pense qu'en effet, une Intelligence artificielle peut faire des discriminations. Plus d'un cinquième (21,7%) pense que non, et le reste (7,2%) n'a pas d'avis.

Lorsque nous avons demandé quels pouvaient être les critères de discrimination en laissant la réponse ouverte, environs le tier des réponses contenait la couleur de peau/ethnie et/ou le genre. Presque un cinquième considérait que toutes les données mises en entrée du système pouvaient être un critère discriminatoire. Une partie pense que ce sont les dévelopeur.se.s qui induisent ces critères, par choix ou par erreur de programmation, et une autre a répondu qu'une IA utilisait les même critères que les humains. D'autres éléments ont été cité, comme les traits du visages, l'âge, le statut social/revenu, le parcours scolaire, l'orientation sexuelle, la religion, ou encore toutes les informations que l'on peut donner sur internet (cookies...), mais en plus faible nombre.

Nous avons alors demandé quelles pouvaient être les causes de discrimination. La plupart des réponses accusaient les personnes qui sont derrière l'IA et qui l'ont programmée, ou une mauvaise base de données, qui serait biaisée et/ou qui manquerait de représentation (soutenant l'idée que des IA étant entrainées principalement sur des visages blancs par exemple auraient plus de mal à reconnaitre les visages noirs ou typés asiatiques). Quelques avis penchent plus sur une cause humaine, au sens large : l'IA immiterait le comportement humain, ou serait influencée par celui-ci.

Nous avons ensuite demandé s'iels avaient déjà subi ou vu des cas de discriminations par des Intelligences Artificielles, ce à quoi une vingtaine de personnes ont répondu positivement. Dans les exemples donnés, nous pouvons noter des publicités ciblées en fonction du genre : des garçons se voyant proposer des annonces sur le foot, l'automobile, le bricolage… même sans avoir fait de recherches en rapport avec ça. Un exemple qui est revenu plusieurs fois aussi est celui d'IA qui étaient lancées sur twitter ou dans des jeux vidéo, et qui évoluaient en fonction des réponses et commentaires des utilisateurs. Très rapidement, ces IA ont commencé à avoir des propos racistes ou sexistes, voir même fascistes dans les cas les plus extrêmes. D'autres cas parlent d'algorithmes qui ne reconnaissent pas (ou moins) les visages noirs, ou mettent en avant les visages blancs sur les miniatures des photos montrant une personne noire et une personne blanche. Des cas d'algorithmes assimilant des personnes noires à des singes ont également été cités.

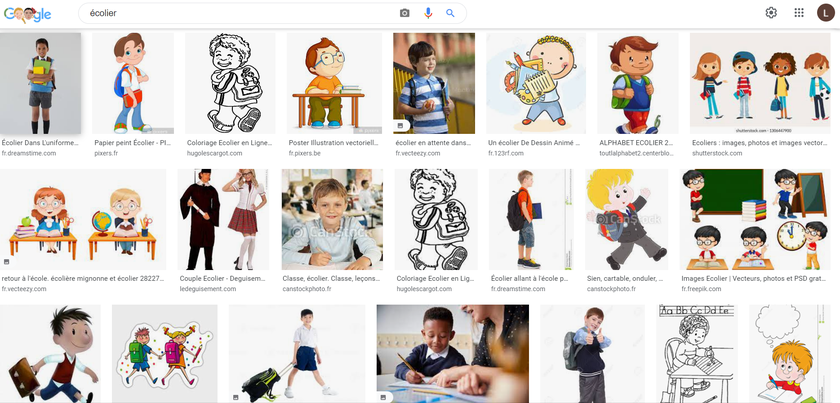

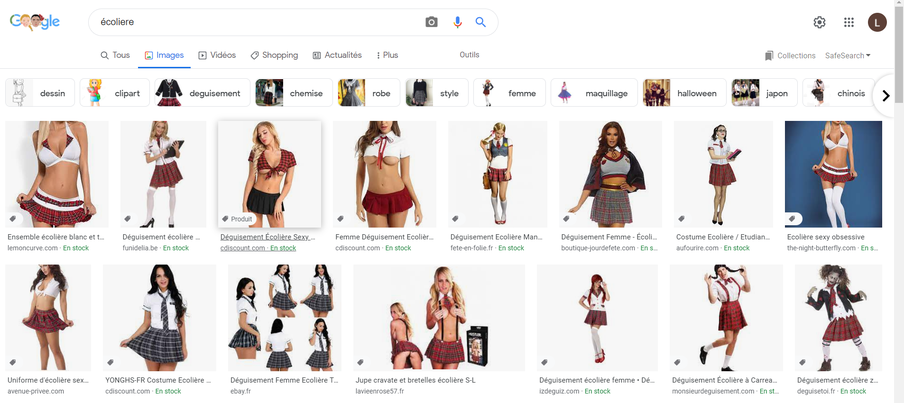

Par la suite, nous avons posé le scénario suivant :

"Un.e instituteur.trice cherche à décorer sa classe pour la rentrée. Iel fait une recherche internet pour trouver des images d'écoliers et d'écolières. Mais les résultats pour les 2 mots ne sont pas les mêmes..."

Suite à quoi nous avons demandé quelle pourrait être la raison d'une différence si frappante entre les deux résultats. Les deux tiers des personnes ayant répondu au sondage pensent qu'elle est causée par les préférences des utilisateurs, qui s'attendent à tomber sur ce résultat. 18% estiment que cela est dû aux erreurs des personnes qui auraient (mal) "formé" l'IA, et seuls 2,4% optent pour un choix assumé des programeur.euse.s. Quelques personnes pensent que la raison est un mélange des trois réponses précédentes. D'autres avis évoquent une origine sociétale, ou due aux stéréotypes.

Toujours dans le cadre du scénario, près de 80% des personnes sont d'avis qu'il faudrait changer ce résultat et ne pas laisser les IA rester dans les stéréotypes sexistes, et 20% pensent qu'il vaudrait mieux le laisser comme il était car il représente ce qu'on attend en général de la recherche.

Pour aller plus loin, nous avons posé un deuxième scénario :

"Vous êtes membre de l'équipe RH d'une entreprise. Vous êtes chargé.e de sélectionner les CV des candidat.e.s au poste. Face au très grand nombre de CV, vous décidez d'utiliser un algorithme d'Intelligence Artificielle pour vous aider à les trier. Après quelques mois à utiliser cet algorithme, vous vous rendez compte qu'il fonctionne bien, mais il rejette plus souvent certains types de profil, en fonction du genre et de l'origine de la personne."

La question posée alors était de savoir s'il fallait changer cet algorithme ou pas. 78,3% des réponses estiment qu'il faut que l'IA soit neutre pour pouvoir l'utiliser, contre 21,7% qui sont favorables à garder l'algorithme s'il nous fait gagner du temps.

Nous avons ensuite poussé le scénario plus loin, en ajoutant comme information que les résultats donnés par l'algorithme sont similaires à ceux précédant son utilisation, lorsque le tri était effectué manuellement par les RH. Le pourcentage de personnes qui étaient pour changer l'algorithme est alors passé de 78 à 63%. Il y a donc 15% de personnes qui pensent qu'il est légitime d'utiliser un tel algorithme, seulement dans la mesure où il renvoie le même résultat que des humains.

Enfin, nous avons légèrement changé le scénario de la sorte : "Vous arrivez à modifier l'IA pour qu'elle ne fasse plus de discrimination sur le genre ou l'origine. Mais vous vous rendez compte que les performances de l'entreprise ont baissé depuis. Décidez-vous de reprendre le premier algorithme ?". Les résultats n'ont pas fortement changé par rapport à la dernière question: 63,9% des personnes continuent de penser qu'il ne faut en aucun cas faire de discriminations sur le genre ou l'origine, contre 36,1% qui optent pour un algorithme plus efficace.

Grace à ce sondage, nous avons pu avoir une idée générale de ce que pensent les personnes de la discrimination par les IA. Une majorité se rendait déjà compte de leur existence, et nous avons ainsi pu recueillir quelques témoignages et exemples d'IA discriminantes. Nous avons également pu remarquer une forte tendance allant à l'encontre de ces discriminations, même si les résultats sont moins tranchés que ce à quoi nous nous attendions en lançant le sondage.

Cependant, l'inconvénient du sondage est qu'il ne permet pas de détailler explicitement son point de vue. Nous avons donc eu l'occasion, en plus du sondage, d'avoir une discussion entre les élèves de la classe, ce qui nous a permis d'avoir des avis plus détaillés.

Une opinion qui est alors beaucoup revenue est que, pour changer les IA, il faut commencer par changer la société. Beaucoup de personnes dans la classe pensent que le comportement des intelligences artificielles dépend directement de la Société, et que si cette dernière continue d'entretenir les inégalités, les IA les reproduiront. Certaines personnes pensaient aussi que garder ces inégalité est volontaire, puisque ces intelligences font ce qu'on attend d'elles. Par exemple, si nous reprenons le cas de la recherche internet écolier/écolière, les résultats donnés sont ceux attendus des utilisateurs, donc il ne faudrait pas le changer.

Nous avons également pu avoir des témoignages, qui nous ont fait nous rendre compte que certaines discriminations (dans le cadre des IA, ou pas forcément), sont dues à un manque crucial de représentation. Par exemple, dans les livres de médecine, il y a très peu (voir pas du tout) d'exemples, de schémas, etc. représentant des peaux noires, menant à des risques pour la santé des personnes concernées. Les discriminations de ce type ne sont donc pas volontaires, mais résultent simplement d'un manque de représentation.

Avis des experts

En complémentarité de l'avis du public, nous avons posé quelques questions à des "experts", qui ont l'habitude de travailler avec des IA, et/ou qui s'y connaissent dans le sujet des discriminations, par vécu et par engagement.

Valentin Honorez :

Ingénieur civil, diplômé de la Faculté Polytechnique de Mons en électricité, IA et télécommunication, Valentin Honorez a travaillé avec de l’Intelligence Artificielle et du deep learning au cours de son cursus. Il a effectué son TFE sur le sujet de l’IA et travaillé dans 2 centres de recherches : multitel et IDIAP en Suisse.

« Une technologie n’est ni bonne ni mauvaise, cela dépend de ce qu’on en fait »

Avez-vous déjà constaté des discriminations dans l’intelligence artificielle ? Si oui, lesquelles ?

« Oui, évidemment, j’en ai déjà constaté. Pour moi, une technologie n’est ni bonne ni mauvaise, cela dépend de ce que l’on en fait. Malheureusement, l’IA est sujette aux biais humains et à la politique. Par exemple, j’ai travaillé avec une base de données qui a été fermée car elle avait été utilisée pour un modèle ayant pour but de traquer les musulmans Ouïgours en Chine. La politique joue un rôle. Au départ, les modèles ne sont pas discriminatoires. Les modèles de Deep learning en soit ne reconnaissent pas plus facilement les femmes que les hommes, par exemple, puisque derrière, ces modèles apprennent par eux-mêmes et trouvent leur propres features et non des features définis par l’homme. Je pense que le biais se trouve au niveau des données. Un humain, avec ses biais, récolte les données qui inconsciemment lui conviennent. Quand il code un modèle, il code d’une certaine façon selon ses principes. C’est ce qui fait que les modèles peuvent être discriminants éthiquement. Il suffit de regarder les différences de mentalités et de cultures et de lois en Occident, en Amérique, en Asie, et ailleurs : chacun a ses propres valeurs et cela influence d’une certaine façon le jeu de données. En conclusion, je pense que le problème ne vient pas de la technologie mais des humains qui l’exploitent. »

Dans votre domaine, quelle est la place accordée à l’IA ? Quel est son rôle ? Si son utilisation entraîne des discriminations, quel peut en être l’impact ?

« Dans mon domaine actuel, la place du DeepLearning est négligeable. En effet, les grosses entreprises ne font pas confiance à un modèle qui a 99% de réussite de dire la bonne chose et 1% de se tromper. Imaginez les répercussions si le modèle se trompe, même une fois. C’est pour cela que généralement on priorisera l’utilisation d’arbres de décisions. J’ai travaillé avec du Deep learning principalement en centre de recherche ou en startup mais à l’heure actuelle, la plupart des entreprises évitent ces modèles car ils évoluent encore de mois en mois or, les entreprises cherchent quelque chose qui a déjà bien muri. Je sais bien que des entreprises telles que Google ou Facebook utilisent ce genre de modèle pour faire du sentiment analysis, du keyword spotting ou autre et je pense que ces modèles sont discriminants oui mais je n’ai pas assez d’informations pour donner un avis complet. »

Pensez-vous qu’il faudrait prioriser le sens moral des recherches internet par rapport au souhait de résultat le plus fréquent de l’utilisateur ? (Ex : écolière / écolier)

« Alors, d’un point de vue éthique oui, mais d’un point de vue technologique, tant que ça n’a pas un grand impact, non. Pour lutter contre ces discriminations, il faudrait beaucoup plus de lois spécifiques au domaine. »

Faut-il lutter contre ces discriminations faites par les IA ?

« Je pense que les gens qui ne connaissent que « deux trois trucs en IA » ne doivent pas lutter, ils ne comprennent pas toute la technologie derrière et prendraient des décisions biaisées par leurs personnalités et leurs cultures. Si maintenant on parle des experts en IA, alors oui car ils pourraient assister des juges, avocats, etc. pour aider à créer des lois viables. »

Quelle(s) solution(s) permettrai(en)t, selon vous, de lutter contre ces discriminations ?

« Comme dit dans la question précédente, il faudrait une assemblée de professionnels de l’IA et de personnes du domaine de la justice pour faire avancer les choses. Les gens qui n’y connaissent rien dans ces deux domaines n’apporteront que du bruit dans le débat. »

Marie-Laure WATTIER :

« Bonjour, je m’appelle Marie-Laure. Je viens de la région du Centre, en Wallonie, Belgique. Je suis une femme Ingénieur Civil en Mines et Géologie, diplômée en 2002. Je suis musicienne dans un groupe de musique métal. Je suis activiste dans une association LGBTQi+ en Belgique. J’ai vécu en tant qu’expatriée pendant 13 ans, et travaillé de façon plus ou moins prolongée en Ecosse, en Allemagne, à Houston Texas, à Dubaï aux Emirats Arabes Unis, au Turkménistan, en Indonésie.

Ma carrière professionnelle a commencé dans le monde de l’énergie, et en particulier dans le forage profond. Après 13 ans dans le domaine pétrolier j’ai rejoint la Belgique et ai entamé un mandant d’assistante-doctorante à la Faculté Polytechnique de l’UMONS. Ma thèse de doctorat traite de mécanique des roches. A la fin de 2022 je souhaite reprendre un travail en industrie avec une part de mobilité.

Je suis issue d’une grande et belle famille, moi-même je n’ai pas d’enfants, et suis dans une relation romantique stable avec une personne originaire de Finlande.

Mon parcours m’a exposée à de nombreuses cultures et points de vue, dans des environnements parfois truffés de technologie, et au contraire, parfois extrêmement basiques, simples, naturels.

Mon expérience internationale m’a confrontée à la réalisation de diverses discriminations envers d’autres et envers moi-même. Certaines discriminations ont été positives, me donnant accès à des privilèges. D’autres ont été négatives, me chargeant de difficultés auxquelles d’autres n’ont pas eu à faire face. Le retour « au pays » me confronte également aux avantages et privilèges invisibles inhérents à la vie en Belgique, et ce, pour ma situation personnelle (en tant que femme, par exemple). »

Avez-vous déjà constaté des discriminations dans l’intelligence artificielle ? Si oui, lesquelles ?

« Je ne suis pas exposée fréquemment à l’IA. Cependant, comme tout.e citoyen.ne je ne peux que constater le biais de genre que l’on rencontre dans les formulaires en ligne, la voix du GPS, les chatbots qui assistent les services bancaires ou d’achat de produits sur le net, etc. A ce propos, je remarque que de nombreux assistants virtuels portent des « noms » féminins. »

D’où pensez-vous que les discriminations proviennent ? Par quoi ou par qui sont-elles causées ?

« Les discriminations sont portées par deux facteurs, je pense. D’une part, le modèle référentiel global, qui est biaisé : le net est biaisé, le volume d’information global qui nourrit les systèmes en apprentissage sont biaisés. D’autre part, les concepteurs des IA sont également responsables du manque de diversité et d’équilibre puisqu’ils (j’utilise le masculin pour les désigner, ce n’est pas anodin) vivent également dans leur propre référentiel. Pour faire simple, tant que le code sera écrit par les « vieux mecs blancs », la machine a peu de chance de suivre des logiques non-biaisées. »

Pensez-vous qu’il faudrait prioriser le sens moral des recherches internet par rapport au souhait de résultat le plus fréquent de l’utilisateur ? (Ex : écolière / écolier)

« CLAIREMENT. D’abord, les outils numériques doivent servir l’humain, pas asservir l’humain. L’éthique, la morale et les considérations de respect des humains doivent donc être au cœur de la conception des outils numériques, built-in, dès la conception.

Aussi, il est plus que temps de s’atteler à ce problème, car la réduction d’efficacité est un leurre. A long terme, un outil biaisé donnera des résultats faussés, donc, que vaut le produit qui produit quantité de matériel de qualité médiocre ?

La calibration de système sur une population biaisée (« vieux mecs blanc ») amène un coût sociétal énorme. Je pense aux médicaments adaptés selon les paramètres physiologiques des hommes occidentaux, aux équipements de sécurités (gilets pare-balle de la police, gilet de secours pour la navigation en mer, masques respirateurs en cas de fuite de gaz ou incendie, gants d’intervention médicaux, casques anti-bruit etc.) conçus pour la morphologie de grands humains masculins, que vaut alors l’outil ? »

Faut-il lutter contre ces discriminations faites par les IA ?

« En plus de réduire l’effectivité des équipements ou des systèmes, ils renforcent les stéréotypes et le biais qui les a forgés.

Maintenant plus que jamais il faut lutter contre les discriminations car ces IA n’en sont qu’à leur débuts, c’est donc moins compliqué d’agir maintenant que de le faire sur des systèmes plus grands, plus étendus, plus puissants dans leurs effets. Il faut les améliorer le plus vite possible. »

Quelle(s) solution(s) permettrai(en)t, selon vous, de lutter contre ces discriminations ?

« L’inclusion et la diversité coulent de source dès qu’on améliore le dialogue. Il faut confronter les IA et leurs créateurs à cette diversité. Nous devons donc créer plus de contenu de référence, et faciliter l’accès aux productions marginales existantes, de façon à augmenter la représentativité.»